Zespół badawczy Google ds. robotyki opracował nowy model języka i robotyki, Palma E, która łączy moc dużych modeli językowych z danymi z czujników robotów. PaLM-E to ogólny model zdolny do wykonywania zadań wzrokowych i językowych, a także efektywnego sterowania i uczenia się robotów.

Jak działa PaLM-E?

PaLM-E działa poprzez wstrzykiwanie informacji zwrotnych do wstępnie wytrenowanego modelu języka i konwertowanie danych z czujników, takich jak obrazy, na reprezentację porównywalną do sposobu przetwarzania słów w języku naturalnym. Modele językowe opierają się na mechanizmie matematycznej reprezentacji tekstu w sposób, który mogą przetwarzać sieci neuronowe. Osiąga się to poprzez podzielenie tekstu na „tokeny”, które kodują słowa i kojarzą je z wielowymiarowymi wektorami. Model języka może zastosować operacje matematyczne do wynikowej sekwencji wektorów, aby przewidzieć następny token słowa. Wstawiając nowo przewidywane słowo do danych wejściowych, model języka może rekurencyjnie generować dłuższy tekst.

Dane wejściowe PaLM-E to teksty i inne modalności, takie jak obrazy, stany robotów i reprezentacje scen, w dowolnej kolejności, co nazywamy „zdaniami multimodalnymi”. Dane wyjściowe to tekst automatycznie generowany przez PaLM-E, który może być odpowiedzią na pytanie lub serią decyzji w formie tekstowej.

Ucieleśniony i multimedialny model

PaLM-E jest oparty na modelu językowym PaLM i architekturze wizyjnej ViT-22B. Ideą PaLM-E jest trenowanie koderów, które konwertują różne dane wejściowe na tę samą przestrzeń, co naturalne śluby. Te ciągłe wpisy są przekształcane w coś w rodzaju „słów”, chociaż niekoniecznie tworzą odrębne grupy. Ponieważ kombinacje słów i obrazów mają te same wymiary, można je wprowadzić do modelu językowego.

PaLM-E to ogólny model, przeznaczony do robotyki, ale zdolny również do zadań wzrokowych i językowych. PaLM-E może opisywać obrazy, wykrywać obiekty, klasyfikować sceny, cytować poezję, rozwiązywać równania matematyczne i generować kod.. Łączy w sobie moc uczenia się opartego na języku z możliwością sterowania robotami i efektywnego uczenia się.

transfer wiedzy

PaLM-E wprowadza nowy sposób uczenia modeli ogólnych, który osiąga się poprzez łączenie robotów z zadaniami wizualnymi i językowymi poprzez połączoną reprezentację: przyjmowanie obrazów i tekstu jako danych wejściowych oraz tworzenie tekstu jako danych wyjściowych. Głównym rezultatem jest to, że PaLM-E osiąga pozytywny transfer wiedzy z dziedziny wizualnej i językowej, co poprawia efektywność uczenia się robota.

Przeniesienie pozytywnej wiedzy z zadań wzrokowych i językowych do robotów umożliwia PaLM-E przetwarzanie szerokiego zakresu zadań robotyki, wzroku i języka jednocześnie, bez pogorszenia wydajności w porównaniu ze szkoleniem pojedynczych modeli w zakresie pojedynczych zadań. Dane wizyjne i językowe znacznie poprawiają wydajność zadań robota. Ten transfer pozwala PaLM-E skutecznie uczyć się zadań robotów pod względem liczby przykładów potrzebnych do rozwiązania zadania..

Wyniki pokazują, że PaLM-E może skutecznie przetwarzać różnorodne zautomatyzowane zadania i język wizualny. Kiedy PaLM-E ma za zadanie podejmować decyzje za bota, jest to połączone z polityką językową niskiego poziomu w celu przetłumaczenia tekstu na działania bota niskiego poziomu.

kilka przykładów

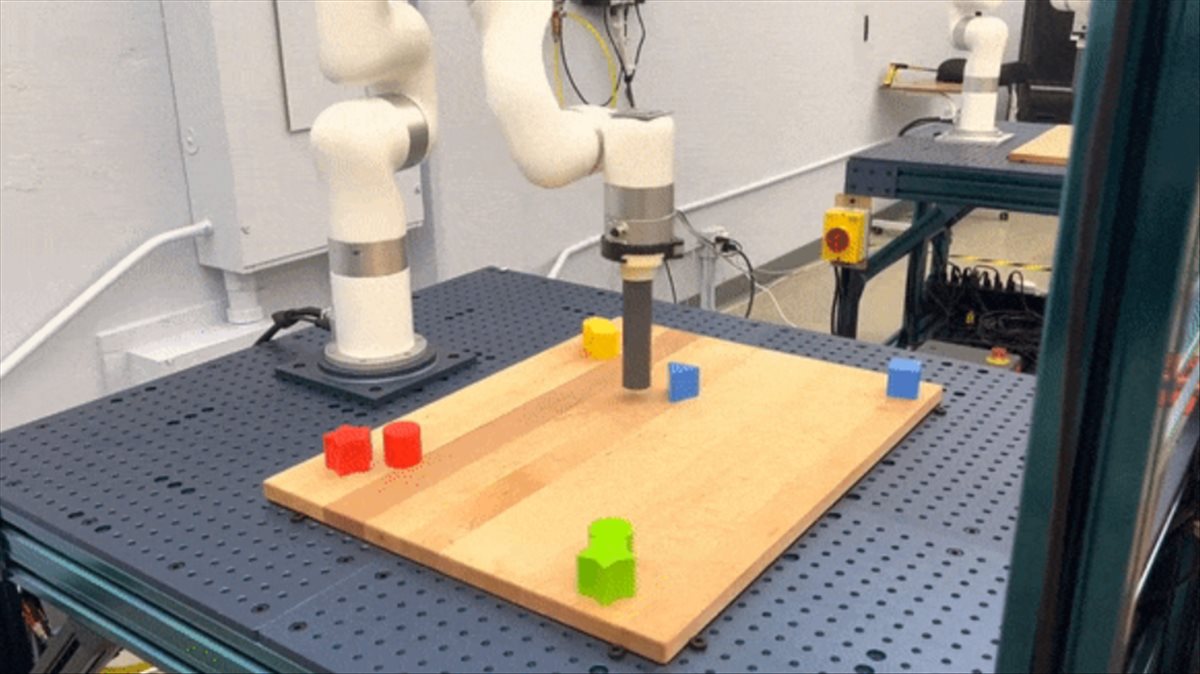

W jednym przykładzie PaLM-E kontroluje poruszającego się robota w kuchni, aby podnieść paczkę chipsów. W innym przykładzie robot miał za zadanie złapać zielony klocek. Chociaż robot nigdy wcześniej nie widział tego bloku, PaLM-E generuje plan krok po kroku, który wykracza poza dane treningowe robota.

W innym ustawieniu model PaLM-E rozwiązuje długoterminowe zadania wyższego poziomu, takie jak „sortowanie bloków według kolorów w rogach” bezpośrednio z obrazów i tworzenie sekwencji działań przedstawionych tekstowo. PaLM-E wykazuje również zdolność uogólniania do nowych zadań, których nie widziano podczas szkolenia, takich jak pchanie czerwonych klocków w kierunku filiżanki kawy.

Bez wątpienia PaLM-E stanowi znaczący postęp w robotyce, łącząc zdolność modeli językowych z transferem wiedzy z zadań wzrokowych i językowych w celu rozwiązania szerokiego zakresu zadań robotycznych. To multimodalne, ucieleśnione podejście ma również potencjał ujednolicenia zadań, które wcześniej wydawały się oddzielne. Zdolność PaLM-E do wydajnego wykonywania zadań związanych z językiem, wizją i robotyką oraz uogólniania do nowych, niewidocznych zadań ma ważne implikacje dla przyszłości robotyki i uczenia się multimodalnego.

Masz więcej informacji na ai.googleblog.com.

„Amatorski praktykujący muzykę. Wieloletni przedsiębiorca. Odkrywca. Miłośnik podróży. Nieskrępowany badacz telewizji.”

:quality(75)/cloudfront-us-east-1.images.arcpublishing.com/elcomercio/G73RL2I77RHUTF4Z247S57H3NM.jpg)

:quality(85)/cloudfront-us-east-1.images.arcpublishing.com/infobae/JCHP4WQPAJE7BLT42T6S57PYRY.jpg)